- امیر سرتیپ خلبان عزیز نصیرزاده وزیر محترم دفاع ، شما بجای ادعای وفق دادن برنامهریزیها با تحولات و تغییرات دنیای جدید ، حق مالکین زمین های غصبی را بعد از ده ها سال زجرکشیدن ، بپرداز

- اولتیماتوم ایران به عراق: ۱۰ روزه فرصت دارید تا نیروهای تروریستی مسلح را خلع سلاح کند

- حاضر جوابی یا دهن کجی سخنگوی وزارت صمت به انتقادات پلیس در خصوص کیفیت خودرو داخلی

- بازی با اعصاب مردم با تمدید و عدم تمدید طرح تقسیط خلافی خودرو، چرا دائمی نمی کنید!

- تامین امنیت به معنای سرکوب نیست، قبل از اعتراض چه کرده اید؟

جمعه ۰۶ تير ۱۴۰۴ - 2025 June 27

جمعه ۰۶ تير ۱۴۰۴ - 2025 June 27

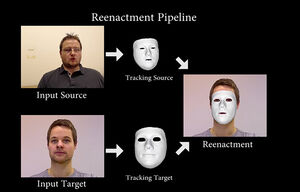

شعار سال: تصور کنید در خانه نشستهاید و با گوشیتان کار میکنید، در همین لحظه دوستتان یک ویدئو برایتان ارسال میکند که در آن با شبیهسازی، چهره شما رو صورت خودش، درباره موضوعات مختلف حرف میزند و اظهار نظر میکند. شما به حرفهایی که از دهان کسی مشابه خودتان خارج میشود، میخندید و احتمالاً ویدئو را در گوشی ذخیره میکنید و باز هم از دیدن آن لذت میبرید!

اما همین تکنولوژی عجیب که برای شما خندهدار و بامزه است، میتواند برای آنهایی که شخصیتهای شناخته شدهای هستند، دردسرساز شوند.

طعم این دردسر را اسکارلت جوهانسون و باراک اوباما چشیدهاند! وقتی از اوباما یک سخنرانی جعلی منتشر و ویدئویی غیراخلاقی از جوهانسون در فضای مجازی دیده شد، با شکایتهای متعدد، استفاده از این برنامه در برخی از وبسایتهایی که پیشتر جابجایی چهره برای سرگرمی به کار میرفت، ممنوع شد.

اما این پایان ماجرا نیست، وقتی «دیپفیک» روز به روز پیشرفتهتر میشود و میتواند شبیهسازی را بهتر و کاملتر انجام دهد، فراگیرتر شده و در نهایت مقابله با آن سختتر میشود. حالا این تکنولوژی نهتنها چهره بلکه شکل اندام را هم میتواند شبیهسازی کند.

وقتی دیگر به ویدئو هم نمیتوان اعتماد کرد

روزگار گذشته وقتی خبری از صحبتهای یک مقام مهم منتشر میشد، در ابتدا صدا مُهر تایید و بعدتر تصویر شخص مدرکی بر واقعی بودن آن بود، اما حالا و با بروز تکنولوژیهایی چون «دیپ فیک» دیگر حتی به ویدئوها هم نمیتوان اعتماد کرد، حالا با یک عکس و صدا میتوان چهره هر فردی را بازسای کرد و حرفها و کارهایی را از او خواست انجام دهد که فرد در زندگی شخصیاش هرگز مرتکب آنها نمیشود.

دیپفیک دقیقاً چیست؟

فناوری دیپ فیک Deepfake ، شکل و حالات نقاط مختلف چهره انسان را از طریق دوربینها کشف کرده و به طرز کاملاً باورپذیری چهره همان انسان را جعل میکند و میتواند او را در حال حرکت، سخنرانی و هر حالتی که فکر کنید قرار دهد. این برنامه در حقیقت یک عروسک خیمه شب بازی دیجیتالی که در محیطهای دیگر، بازتولید میشود.

متأسفانه ظهور deepfakes پس از بیشتر از یک دهه اشتراک گذاری تصاویر شخصی در شبکههای آنلاین آغاز شده تا جاییکه حالا تقریباً تصاویر تمام چهرهها را در اینترنت میتوان پیدا کرد. حتی دور ماندن از دید عموم، مانع از تلفیق Deepfake نخواهد شد ؛ امروزه این امری اجتناب ناپذیر است و هر کسی در جهان در معرض آن قرار دارد، به هر حال حتی اگر کسی اهل انتشار عکس در پروفایل و حسابهای کاربری شخصی نباشد، هرکسی در تصاویر و فیلمهای دوستانش دیده میشود، خیلیها موبایلهایشان با قفل تشخیص چهره کار میکند، تماسهای تصویری یا ویدئو کنفرانسهای آنلاین، همه و همه باعث میشود که شکلهای مختلف و در مورادی به طور ناخواسته تصویر چهره هر فردی در اینترنت به اشتراک گذاشته شود.

دیپفیک چطور کار میکند؟

این برنامه با روش یادگیری ماشین کار میکند و برای جعل چهره، به چند صد تصویر از حالات مختلف چهره هدف نیاز دارد. در این میان افراد شناخته شده و معروف که به سادگی و با یک سرچ اینترنتی تصویر و ویدئوهای مختلف از آنها موجود است، بیشتر در معرض خطر هستند.

این تکنولوژی توسط تیمی با رهبری دانشمندان دانشگاه استنفورد ساخته شده است، آنها یک هوش مصنوعی ایجاد کردند که میتواند با استفاده از الگوریتمها حرکات صورت شخص را مورد بررسی قرار دهد و با ایجاد یک ماسک دیجیتالی با کمترین مشکل و با بیشترین انطباق چهره فرد دیگری را شبیهسازی میکند.

هوش مصنوعی ابتدا تمام چهره را تجزیه و تحلیل کرده و تمام بخشهای صورت را با دقت اسکن میکند، تمام حرکات از جمله چرخش سر، حرکت چشم و جزیئات حرکات دهان مورد بررسی قرار میگیرد. پس از آن نرمافزار تمام دادهها را در حافظه خود ذخیره و روی ویدئوی هدف بارگزاری میکند.

سایت شعار سال، با اندکی تلخیص و اضافات برگرفته از سایت خبری مشرق ، تاریخ انتشار 1تیر98، کد خبر: 968810، www.mashreghnews.ir